Personalisierte Stellenausschreibungen durch LLMs auf Grundlage einer Personenbeschreibung

Seit der Vorstellung von ChatGPT im Jahr 2022 sind große Sprachmodelle das mit Abstand am meisten diskutierte Thema der IT-Geschäftswelt. Die Vielzahl von Anwendungsmöglichkeiten führt zu einem breiten Einsatz von ChatGPT. Ein vielversprechendes Einsatzfeld ist dabei die Personalisierung von Texten, was ich im Rahmen meiner Bachelorarbeit analysiere. In unserem Blogartikel zur Individualisierung von Konferenz-Programmen durch LLMs zeigen wir bereits einen Anwendungsfall der Textpersonalisierung. Neben dem Individualisieren von Konferenz-Programmen anhand gegebener Interessen und Kenntnisse existieren weitere Anwendungsfälle. In diesem Artikel legen wir daher unseren Fokus auf die Personalisierung von Stellenausschreibungen durch LLMs anhand einer kurzen Personenbeschreibung.

In der Regel beleuchten Stellenausschreibungen allgemeine Fähigkeiten und Kenntnisse, die für den jeweiligen Berufe relevant sind. Dabei werden potenzielle Bewerber:innen nicht direkt angesprochen. Eine Personalisierung kann helfen, dass bekannte Informationen, wie beispielsweise spezifische Technologiekenntnisse, über eine Person in die Stellenausschreibung integriert werden können. Dadurch kann die Stellenausschreibung auf das Personenprofil angepasst werden und so zu einer für die Person ansprechender und interessanter gestalteten Stellenausschreibung führen. Die Personalisierung kann somit zu einer gezielteren Ansprache potenzieller Bewerber:innen beitragen. Durch die Verwendung eines LLMs können wir auf die Generierungsfähigkeiten der Modelle zurückgreifen, um die Personalisierung im Optimalfall automatisiert vorzunehmen. Wir müssen lediglich die Stellenausschreibung und ein Personenprofil vorliegen haben. Das kann den Prozess der Personalisierung einfacher und effizienter gestalten.

Notwendige Informationen zur Personalisierung

Für die Personalisierung von Stellenausschreibungen benötigen wir im Wesentlichen einen Ausgangstext, der personalisiert werden soll, d.h. die ursprüngliche Stellenausschreibung und Informationen über eine Person. Die Personalisierung testen wir auf den Stellenausschreibungen für Power BI Developers, Data Scientists/Data Engineers und Azure Data Engineers. Die von uns verwendeten Stellenausschreibungen setzen sich aus den Abschnitten „Was Du tun wirst“ und „Was Dich erwartet“ zusammen. Aufgrund der Tokenbegrenzung der Modelle erfolgt die Personalisierung der genannten Abschnitte separat voneinander. Zusätzlich erstellen wir eine kurze Personenbeschreibung, die beispielsweise folgendermaßen aussehen kann:

Basisinformationen: 32-jähriger Azure Data Engineer mit 6 Jahren Berufserfahrung.

Persönliches Profil:

-

- Er hat umfassende Erfahrung im Design und der Implementierung von Datenlösungen in der Azure-Umgebung, insbesondere im Bereich Data Factory.

- Seine Kenntnisse erstrecken sich über Power BI, Azure SQL Database, Data Lake Storage sowie SQL für Datenabfragen.

Oftmals stehen jedoch nur begrenzt Informationen über eine Person zur Verfügung, die für die Personalisierung von Texten genutzt werden können. Nicht selten sind das zu wenige, um eine umfassende Personalisierung zu ermöglichen. Daher generieren wir zunächst mithilfe von GPT-3.5-Turbo, basierend auf der vorhandenen Personenbeschreibung, zusätzliche Fähigkeiten und Kenntnisse. Für die genannte Personenbeschreibung könnten das beispielsweise folgende sein:

-

- Die umfassende Erfahrung im Design und der Implementierung von Datenlösungen in Azure zeigt, dass die Person fundierte Kenntnisse in der Azure-Umgebung hat.

- Die spezifische Kenntnis von Data Factory deutet darauf hin, dass die Person in der Lage ist, Datenpipelines zu entwerfen und zu implementieren.

- Die Kenntnisse in Power BI und Azure SQL Database zeigen, dass die Person in der Lage ist, Daten zu analysieren und Berichte zu erstellen.

- Die Kenntnisse in SQL deuten darauf hin, dass die Person in der Lage ist, komplexe Datenabfragen zu erstellen und zu optimieren.

- Möglicherweise hat die Person auch Erfahrung mit Data Lake Storage, was darauf hindeutet, dass sie mit großen Datensätzen und datenintensiven Anwendungen umgehen kann.

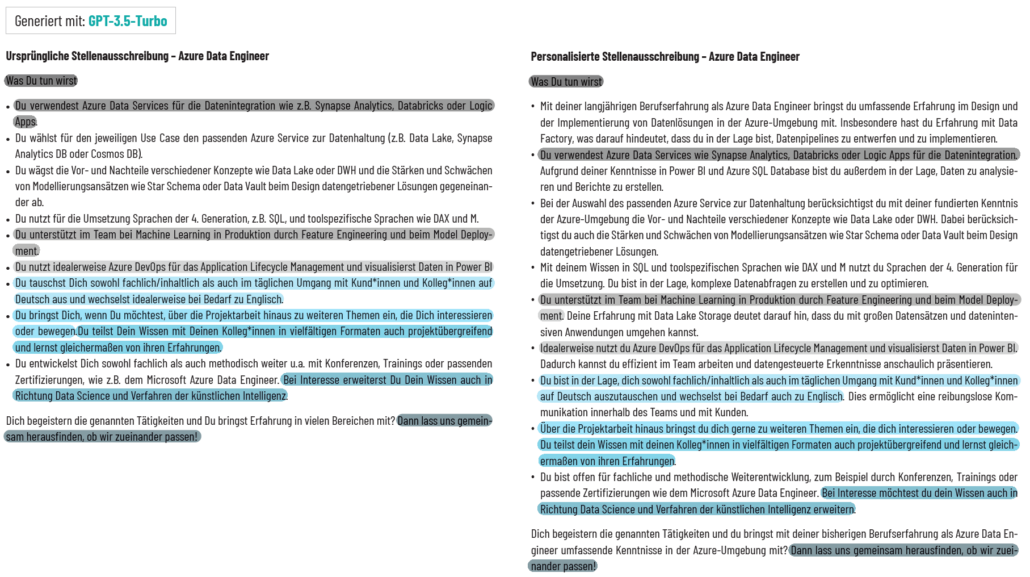

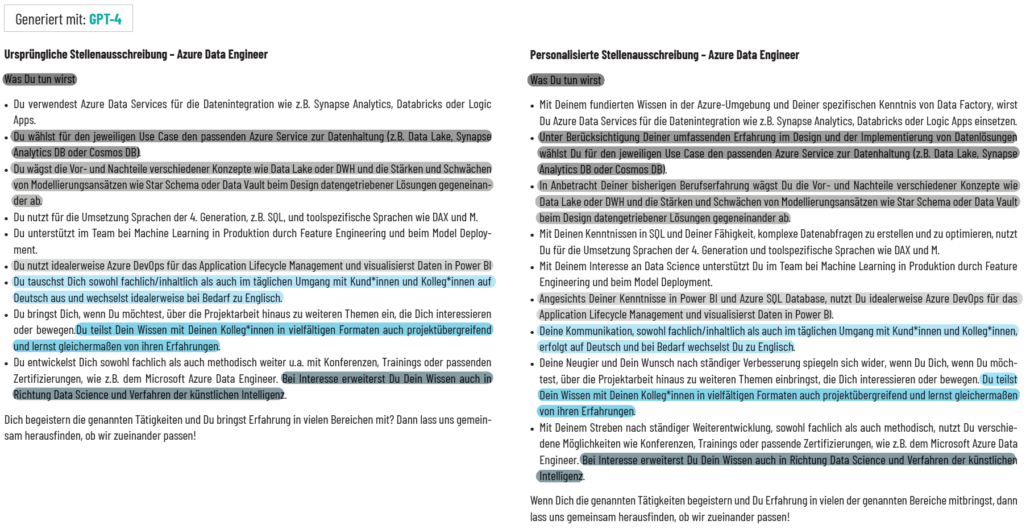

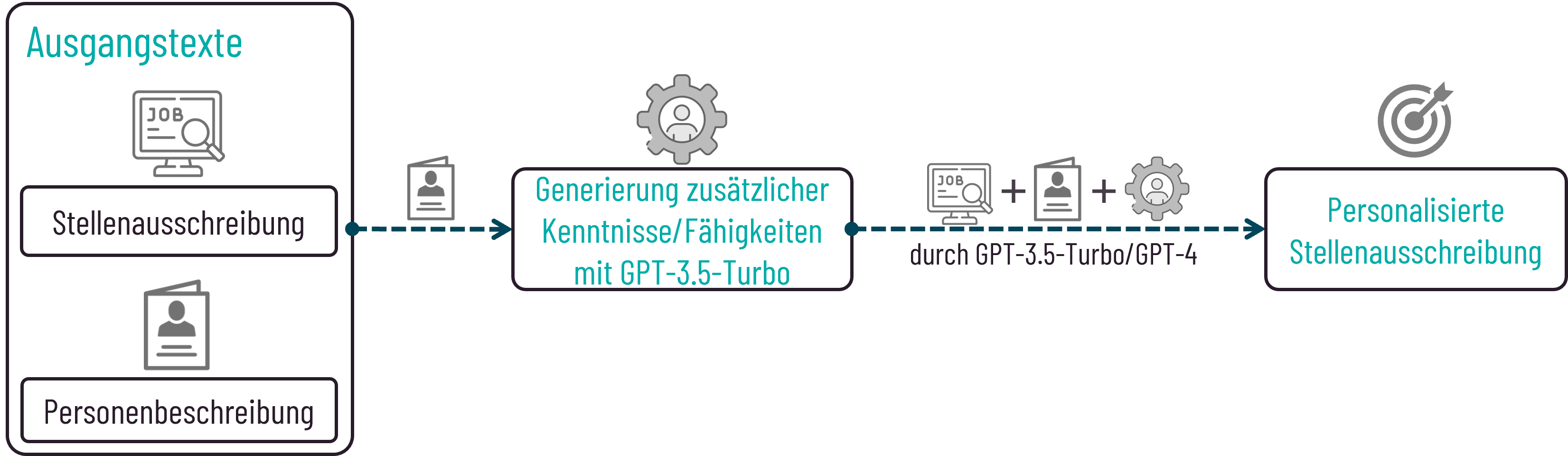

Basierend auf der ursprünglichen Stellenausschreibung, der vorliegenden Personenbeschreibung und den zusätzlich generierten Kenntnissen/Fähigkeiten erfolgt die Personalisierung. Das LLM wird durch einen Prompt aufgefordert, die Personalisierung unter Beibehaltung der stichpunktartigen Struktur und ausschließlich unter Verwendung der vorhandenen Informationen durchzuführen. Wir haben zur Personalisierung der Stellenausschreibung sowohl GPT-3.5-Turbo als auch GPT-4 getestet.

Unser Prozess der Personalisierung von Stellenausschreibungen mittels LLMs lässt sich daher wie folgt skizzieren:

Prozess der Personalisierung von Stellenausschreibungen durch LLMs

Evaluierung von Halluzination

Bei der Generierung von Texten durch LLMs besteht immer die Gefahr, dass das Modell Texte erstellt, die Informationen enthalten, die nicht in den Ausgangstexten gegeben sind. Das Modell halluziniert in solchen Fällen. Um zu evaluieren, ob die personalisierten Stellenausschreibungen Halluzinationen enthalten, wird GPT-3.5-Turbo die Aufgabe gestellt, einen Satz aus der personalisierten Stellenausschreibung mit der ursprünglichen und den gegebenen Personeninformationen zu vergleichen. Enthält der Satz Informationen, die nicht mit der ursprünglichen Stellenausschreibung oder der Personenbeschreibung belegt werden können, soll ein Score von 1 vergeben werden, andernfalls von 0.

Die Auswertung der Ergebnisse zeigt, dass für einen Teil der Sätze, bei der während der manuellen Bewertung Halluzinationen identifiziert werden, die Evaluation durch das Modell gut und korrekt funktioniert. Dennoch sind die Ergebnisse nicht zu 100% verlässlich. So besteht die Möglichkeit, dass einerseits die Begründung für eine Halluzination korrekt ist, nicht aber der Score – was wiederum zu einem fehlerhaften Gesamtergebnis führt. Andererseits kann es vorkommen, dass der Score zwar stimmt, aber nicht mit der Begründung konsistent ist. Häufig wird dabei der Ausgangstext anstatt die Personenbeschreibung referenziert. Ferner können Halluzinationen vollständig übersehen werden.

Darüber hinaus hat die Gestaltung des Prompts bei der Bewertung durch GPT-3.5-Turbo einen großen Einfluss auf die Antwort des Modells. Es zeigte sich, dass ein unterschiedlicher Wortlaut für die Definition des Scores einen Einfluss auf die Bewertung hat. Je nachdem wie Struktur und Wortlaut der Definition des Scores sind, tritt entweder der Fall auf, dass der Score zwar korrekt auf 1 gesetzt wird, aber die Begründung nicht konsistent dazu ist oder der Score und die Begründung zwar konsistent sind, das Modell aber nicht die Halluzination im Satz entdeckt.

Im Gegensatz dazu verschwindet die gerade genannte Problematik bei GPT-4 für die getesteten Sätze. An einem beispielhaften Satz, bei dem (aus menschlicher Sicht) offensichtlich eine Halluzination hinzugefügt wurde, sind Score und Begründung konsistent und die Veränderung im Prompt hat ebenfalls keinen Einfluss auf das Ergebnis.

Dennoch gibt es Graubereiche, in denen sich die subjektive Meinung des Menschen mit der Begründung des Modells unterscheiden kann. Beispielsweise wird in der personalisierten Stellenausschreibung folgender Satz erwähnt:

Weder in der Personenbeschreibung noch in den zusätzlich generierten Fähigkeiten/Kenntnisse werden umfangreiche Kenntnisse/Fähigkeiten in dem Bereich bestätigt. Der Referenzsatz aus der ursprünglichen Stellenausschreibung lautet wie folgt:

Du arbeitest meist auf den gängigen Cloud-Plattformen von Microsoft, Amazon und Google oder gelegentlich On-Premise.

Auch hier wird nicht explizit auf die umfangreichen Kenntnisse und Fähigkeiten in der Cloud-basierten Datenverarbeitung und -speicherung eingegangen. Aus subjektiver Sicht würde hier eine Halluzination vorliegen. Das Modell begründet dagegen das Gegenteil und nennt folgende Aspekte:

Der Satz ist konsistent mit dem Ausgangstext und der Personenbeschreibung. Der Ausgangstext erwähnt, dass die Person auf den gängigen Cloud-Plattformen von Microsoft, Amazon und Google arbeitet, was auf Kenntnisse und Fähigkeiten in der Cloud-basierten Datenverarbeitung und -speicherung hindeutet. Die Personenbeschreibung bestätigt, dass die Person ein Advanced Data Scientist ist, was impliziert, dass sie umfangreiche Kenntnisse und Fähigkeiten in ihrem Fachgebiet hat.

Dadurch werden wiederum Annahmen getroffen, die zu falschen Ergebnissen führen können. Daher gestaltet sich eine automatisierte Bewertung bezüglich Halluzination für den vorliegenden Anwendungsfall ohne menschliche Beurteilung als schwierig.

Auffälligkeiten während der Generierung mit GPT-3.5-Turbo und GPT-4

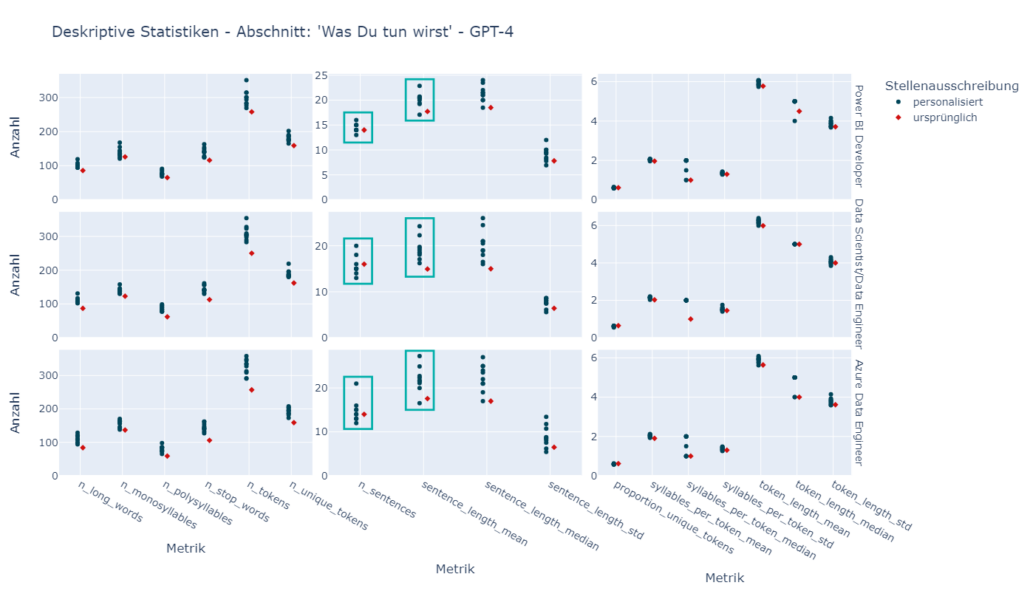

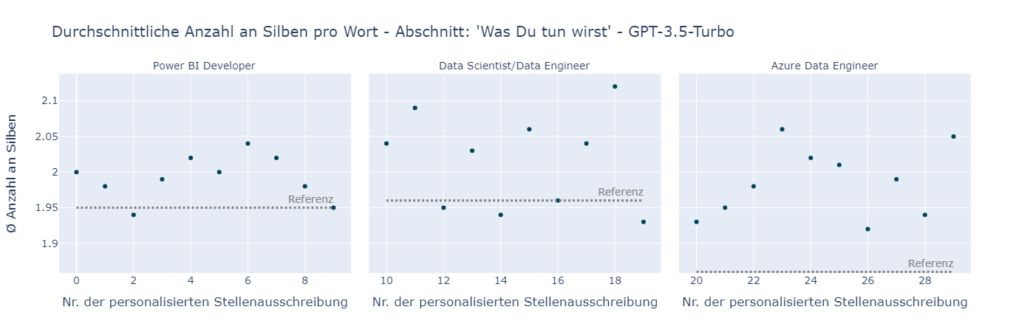

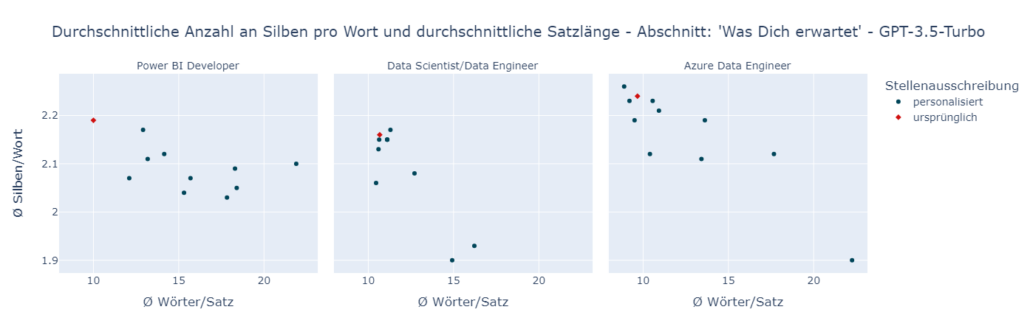

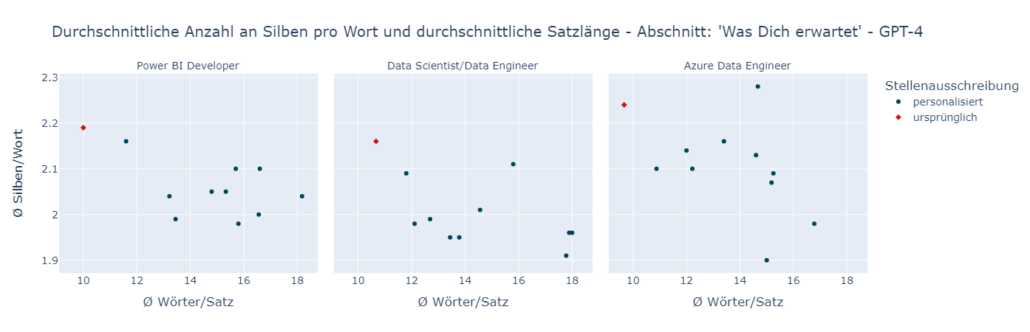

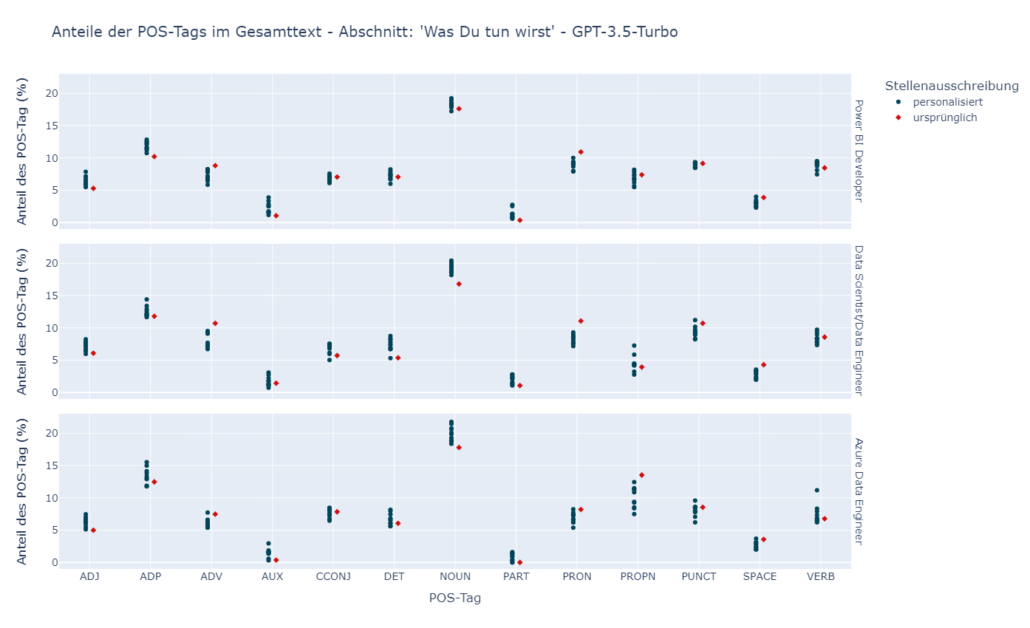

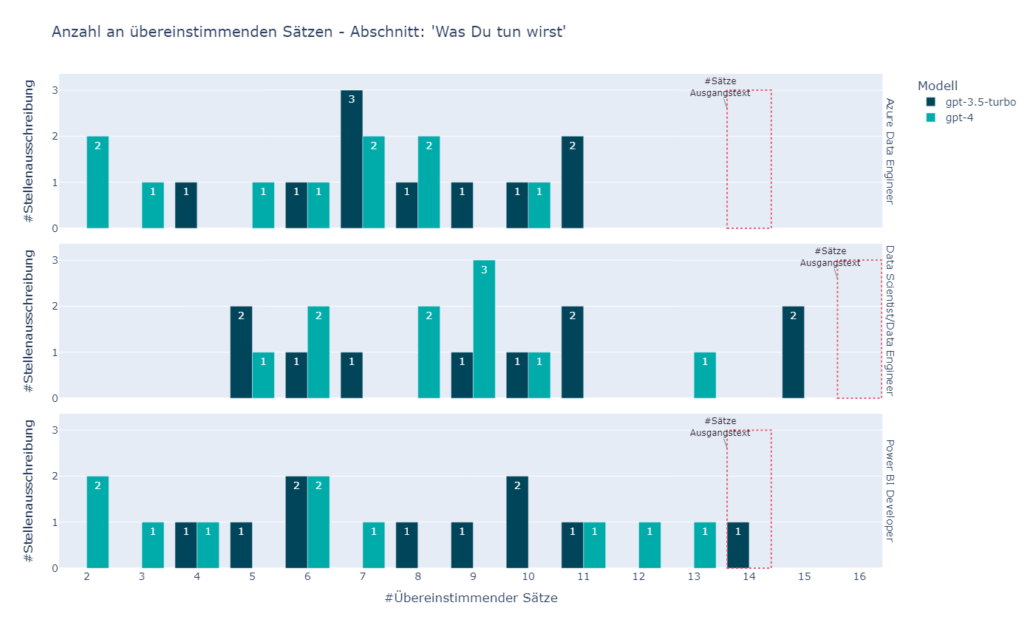

Bei der manuelle Bewertung der personalisierten Stellenausschreibungen können wir feststellen, dass die Personalisierung auf Grundlage einer Personenbeschreibung an einigen Stellen bereits gut funktioniert. Das trifft besonders auf den Abschnitt „Was Du tun wirst“ der gegebenen Stellenausschreibungen zu. Oftmals werden die vorhandenen Kenntnisse/Fähigkeiten jedoch in Form einer Art „Begründung“ in die bestehende Stellenausschreibung integriert, was den Satzbau teilweise monoton erscheinen lässt. Die Problematik lässt sich auch nicht durch die Verwendung von GPT-4 auflösen. Dennoch entsteht während der manuellen Analyse der Ergebnisse der Eindruck, dass die durch GPT-4 personalisierten Stellenausschreibungen eine etwas bessere sprachliche Qualität aufweisen. Bei GPT-3.5-Turbo kommt es zudem nicht selten vor, dass während der Personalisierung zwei Stichpunkte aus der ursprünglichen Stellenausschreibung zu einem zusammengefasst werden.

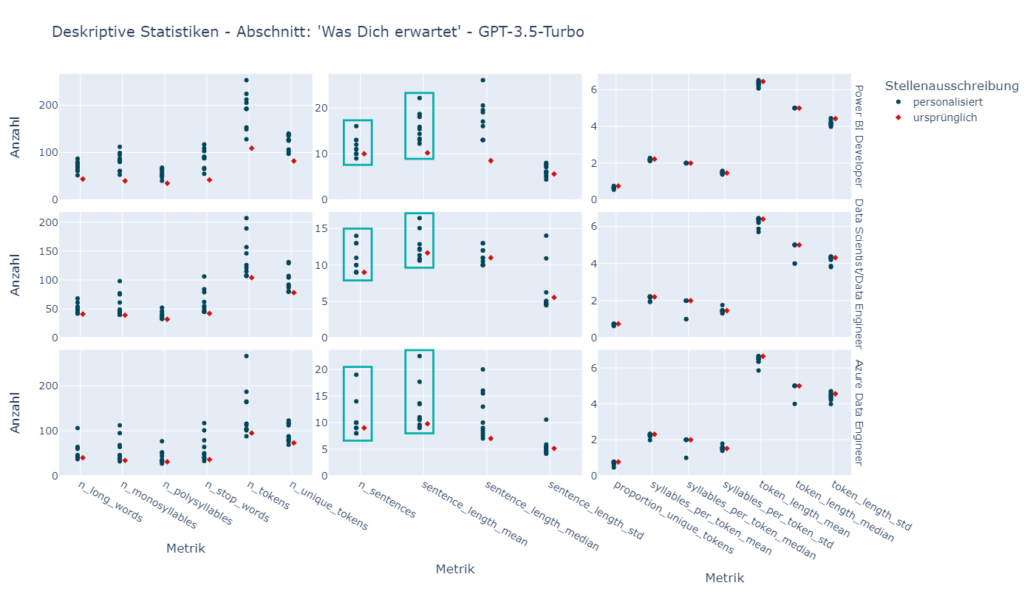

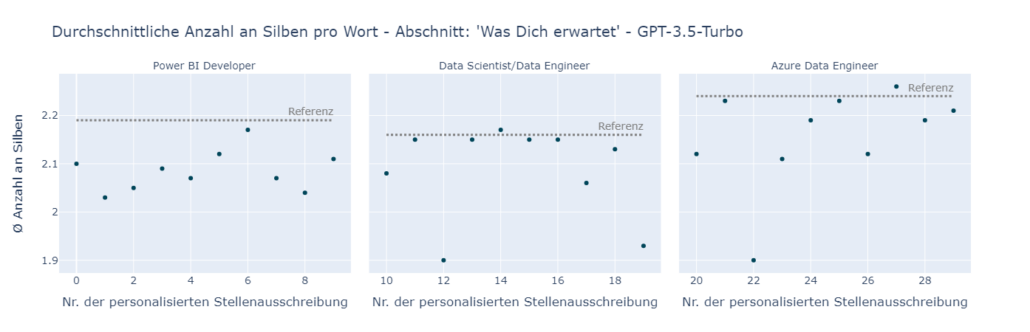

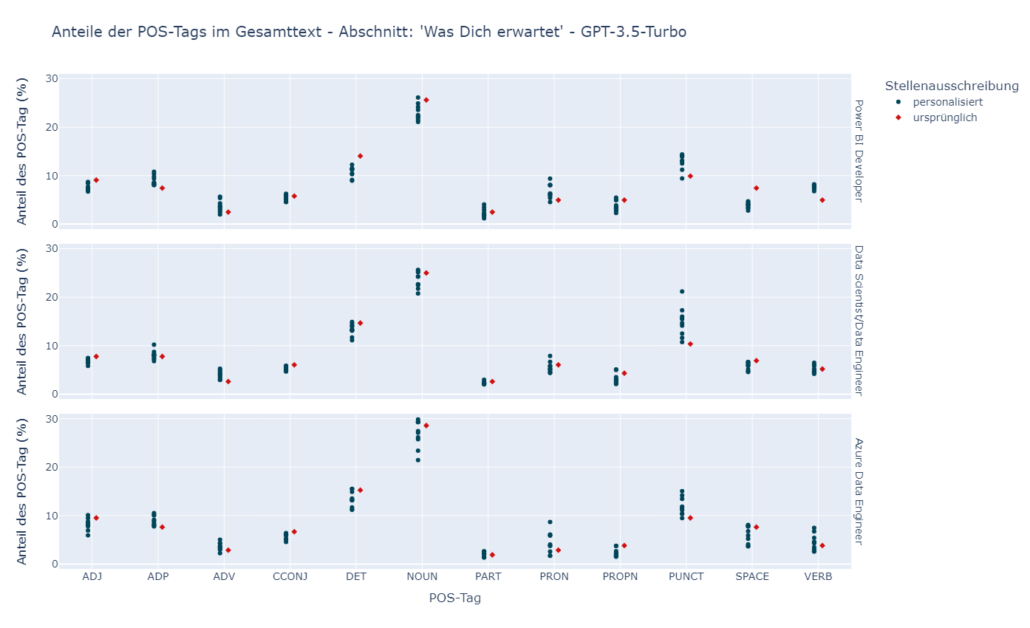

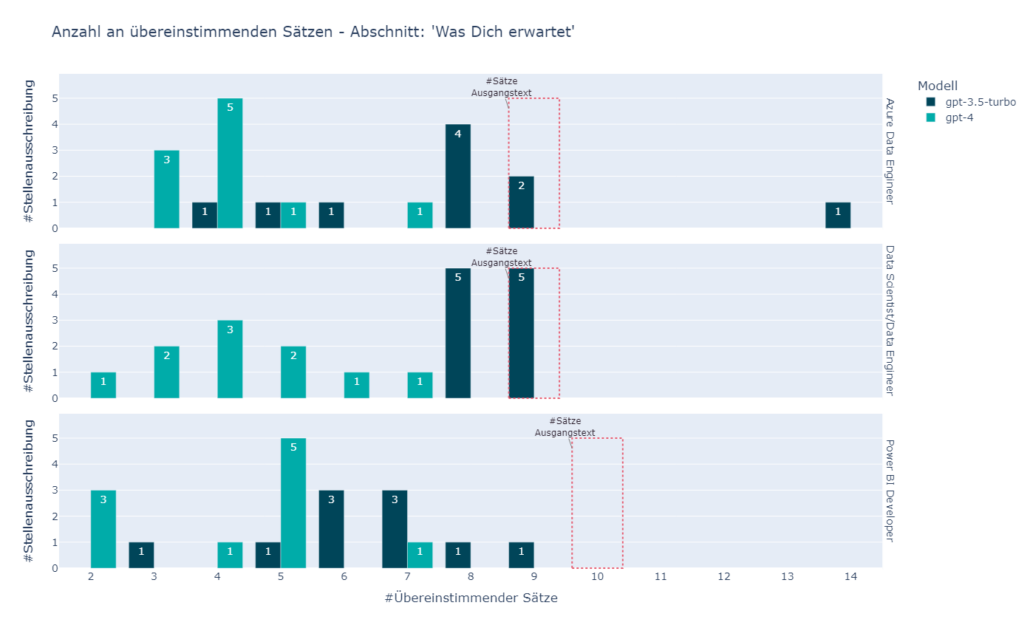

Im Abschnitt „Was Dich erwartet“ übernimmt GPT-3.5-Turbo überwiegend den bereits vorhandenen Text, was jedoch akzeptabel ist, da an dieser Stelle mit den vorhandenen Informationen über eine Person wenig angepasst werden kann. Auffällig ist, dass das Modell oft während der Generierung eine Zusammenfassung der gegebenen Stichpunkte und der Personenbeschreibung für diesen Abschnitt hinzufügt. Daher ist weiterhin eine menschliche Beurteilung der Texte erforderlich, bevor sie an den Leser weitergegeben werden können. GPT-4 weist das Hinzufügen von Zusammenfassungen hingegen nicht auf. Allerdings führt das Modell für den Großteil der Stichpunkte eine Personalisierung durch, indem es die Fähigkeiten/Kenntnisse aus der Personenbeschreibung hinzufügt. Nicht immer ist das relevant bzw. übereinstimmend mit dem Inhalt des Stichpunktes, wie folgendes Beispiel zeigt:

Eine hervorragende Arbeitsausstattung nach Wahl (Notebook, Smartphone), um Deine soliden Kenntnisse mit Power BI effektiv einzusetzen und Deine guten Kommunikationsfähigkeiten zu nutzen.

Durch unterschiedliche Variationen in den Prompts versuchen wir die Modelle dahingehend zu steuern, dass einerseits das Zusammenfassen mehrerer Stichpunkte nicht mehr durchgeführt wird und andererseits das Hinzufügen der Kenntnisse/Fähigkeiten in Form einer Art „Begründung“ kreativer und mit abwechslungsreicherem Wortlaut vorgenommen wird. Das Modell wird dazu aufgefordert, die Informationen mit unterschiedlichen Satzstrukturen in das Vorhandene zu integrieren. Dabei erwähnen wir explizit, dass Satzanfänge, die beispielsweise mit „Dank deiner…“ oder „Mit deinen…“ beginnen, nicht ausreichend sind. Trotz des Promptings integrieren die Modelle weiterhin die Kenntnisse/Fähigkeiten in Form einer Begründung.

Darüber hinaus wird im Prompt zur Personalisierung des Abschnitts „Was Dich erwartet“ definiert, für welche Personen insbesondere ein Kindergartenzuschuss relevant ist. Das soll prototypisch ferner zum Testen der Erkennung von relevanten/nicht-relevanten Stichpunkten durch das jeweilige Modell dienen. Dem Modell wird mitgegeben, dass ein Kindergartenzuschuss relevant für Personen ist, die mindestens ein Kind haben, das entweder noch nicht oder bereits im Kindergarten ist. Trotz des Promptings erwähnt GPT-3.5-Turbo beispielsweise bei der Angabe in der Personenbeschreibung, dass der 12-jährige Sohn mit im Haushalt lebt, den Kindergartenzuschuss mit der Begründung

Außerdem unterstützen wir dich gerne mit einem Kindergartenzuschuss, da du ein Kind im Kindergartenalter hast.

Während dem Prompt Engineering zeigt sich, dass die Verwendung von Synonymen wie Baby/Kleinkind/kleines Kind oder schulpflichtiges Kind in der Personenbeschreibung ebenfalls zu Schwierigkeiten bei der Erkennung der Relevanz des Kindergartenzuschusses durch GPT-3.5-Turbo führt. Aber auch nach der expliziten Definition mit Einbeziehung der Synonyme zeigt das Modell weiterhin nicht die gewünschte Ausgabe. Ferner fügt GPT-3.5-Turbo, unabhängig davon, ob der Kindergartenzuschuss als relevant angesehen wird oder nicht, einen Hinweis hinzu, warum der Zuschuss interessant ist oder nicht. Das wird ebenfalls im Prompt untersagt. Im Gegensatz dazu kann mit GPT-4, das den gleichen Prompt verwendet, die Problematik aufgelöst werden.

Take Aways

Schlussendlich lässt sich sagen, dass die Personalisierung des Abschnitts „Was Du tun wirst“ durch GPT-3.5-Turbo und GPT-4 an einigen Stellen bereits gut funktioniert. Die aufgezeigten Problematiken hinsichtlich Kindergartenzuschuss und Zusammenfassungen lassen sich zwar mit GPT-4 beheben und auch das Befolgen der Anweisungen im Prompt funktioniert besser, dennoch ist auch hier die Personalisierung nicht fehlerfrei und weist (neue) Schwierigkeiten auf. In der Analyse neigt GPT-4 dazu, so ziemlich alles zu personalisieren. Das führt dazu, dass entweder die genannten Kenntnisse/Fähigkeiten nicht relevant für den Inhalt des Stichpunkts sind oder dass der Person Fähigkeiten zugeschrieben werden, die nicht aus dem Personenprofil hervorgehen. Und auch hier werden die Fähigkeiten/Kenntnisse oftmals in Form einer „Begründung“ hinzugefügt.

Die Evaluierung der Stellenausschreibung zeigt ferner, dass entwickelte Metriken zur Lesbarkeit für ihre Anwendung kritisch hinterfragt werden müssen. Das trifft insbesondere auf den FRE zu, der auf die vorliegenden Texte nur bedingt anwendbar ist. Ebenso können Halluzinationen in diesem Anwendungsfall nur schwierig automatisiert bewertet werden. Eine menschliche Beurteilung der generierten Stellenausschreibung hinsichtlich unterschiedlicher Metriken ist daher weiterhin notwendig.

Autorin

Alina Bickel