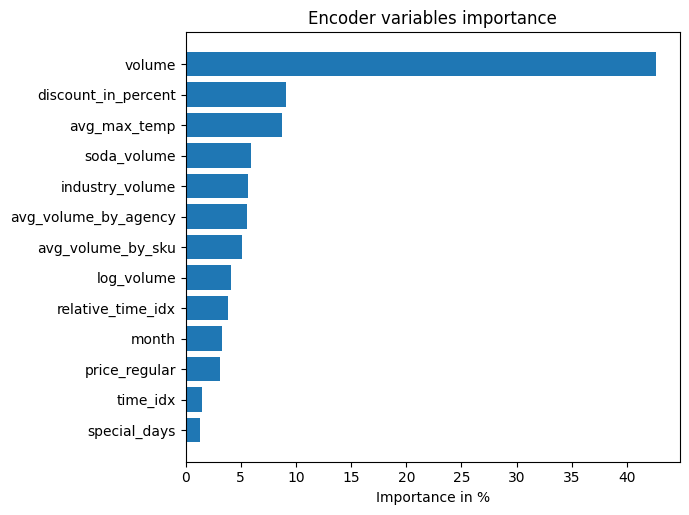

Nein. TFTs erzielen in vielen Studien, und auch in dieser Masterarbeit, bessere Vorhersagegenauigkeiten als andere Vorhersagemodelle. Doch wie bei allen Machine Learning Modellen muss hierfür eine kritische Masse an Trainingsdaten vorliegen, die zwar bei TFTs durch Data Fusion kleiner ausfällt, aber trotzdem erreicht werden muss. Außerdem gestaltet sich die Implementierung von TFTs gerade im Vergleich zu statistischen Modellen als komplex und erfordert somit viel technisches Wissen. Domänen-Expertise lässt sich hingegen sehr gut einbinden, so dass mit dem richtigen Team schnell ein robustes und leistungsstarkes Modell entsteht. Es existieren Implementierung des TFT-Modells – im Rahmen dieser Arbeit wurde das TFT-Modell der Python-Bibliothek PyTorch Forecasting verwendet – welche einen guten Startpunkt bieten, aber ggf. für den eigenen Anwendungsfall angepasst werden müssen.

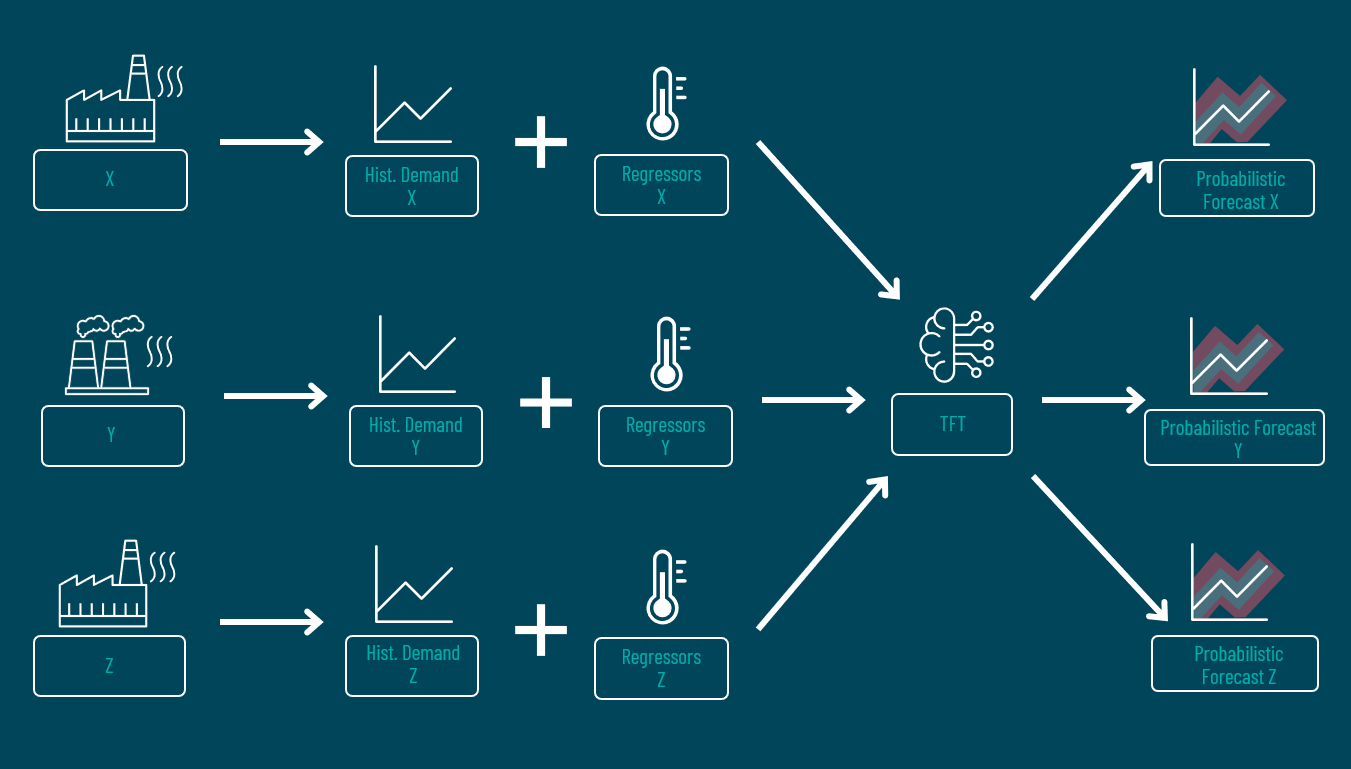

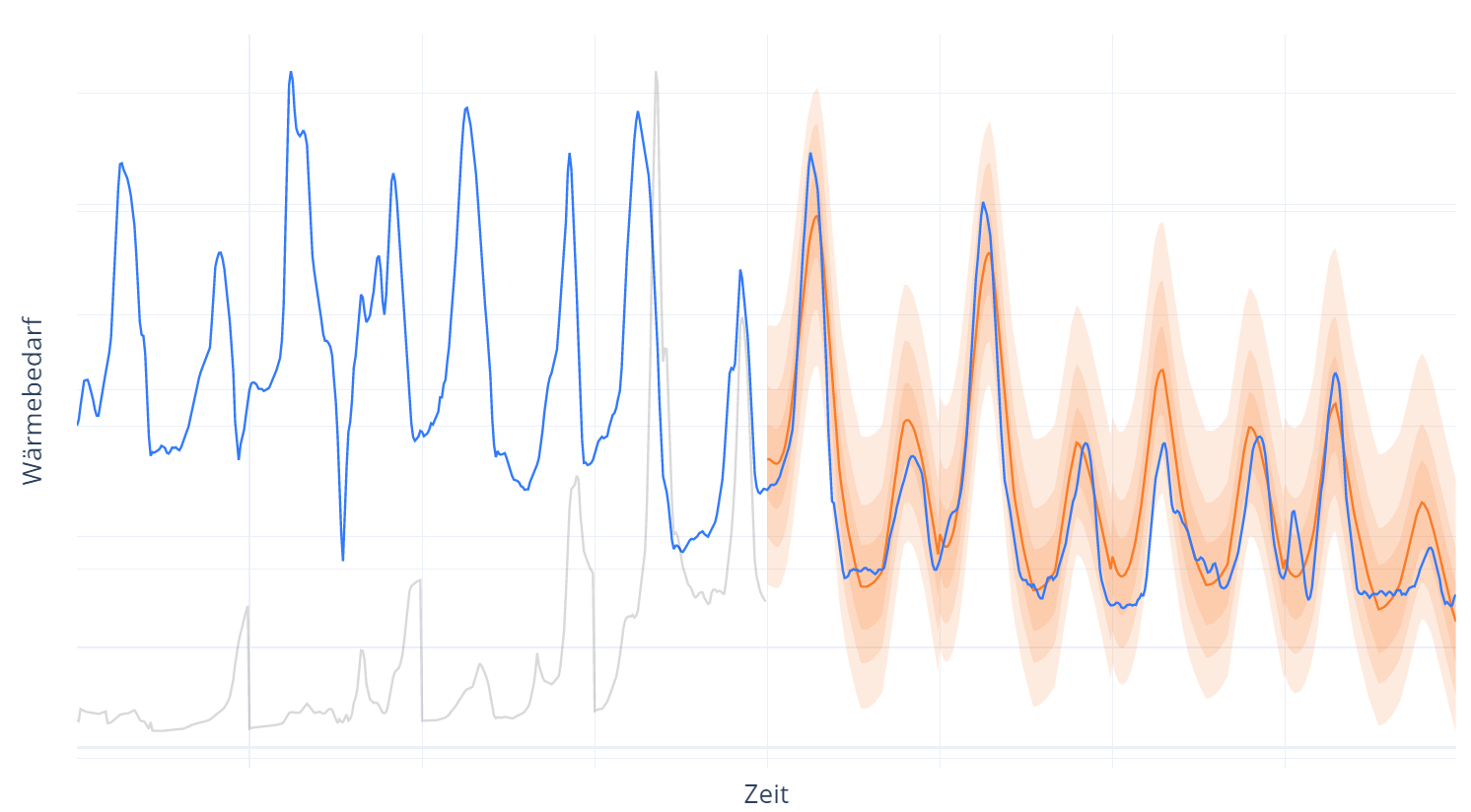

TFTs sind prädestiniert für die Vorhersage von Zeitreihen verschiedener Modalitäten, welche in einem Modell vereint werden und bei denen übergreifende Muster zu erwarten sind. Sie erlauben den Aufbau einer skalierbaren Vorhersage-Architektur und folgen dem Trend von erklärbaren Modellen. Weiterhin wird die Unsicherheit der Vorhersage quantifiziert, was die Entscheidungsfindung erleichtert. Für einfache Anwendungsfälle reicht aber weiterhin ein klassisches ARIMA-Modell, welches mit deutlich weniger Aufwand und Wissen implementiert werden kann.