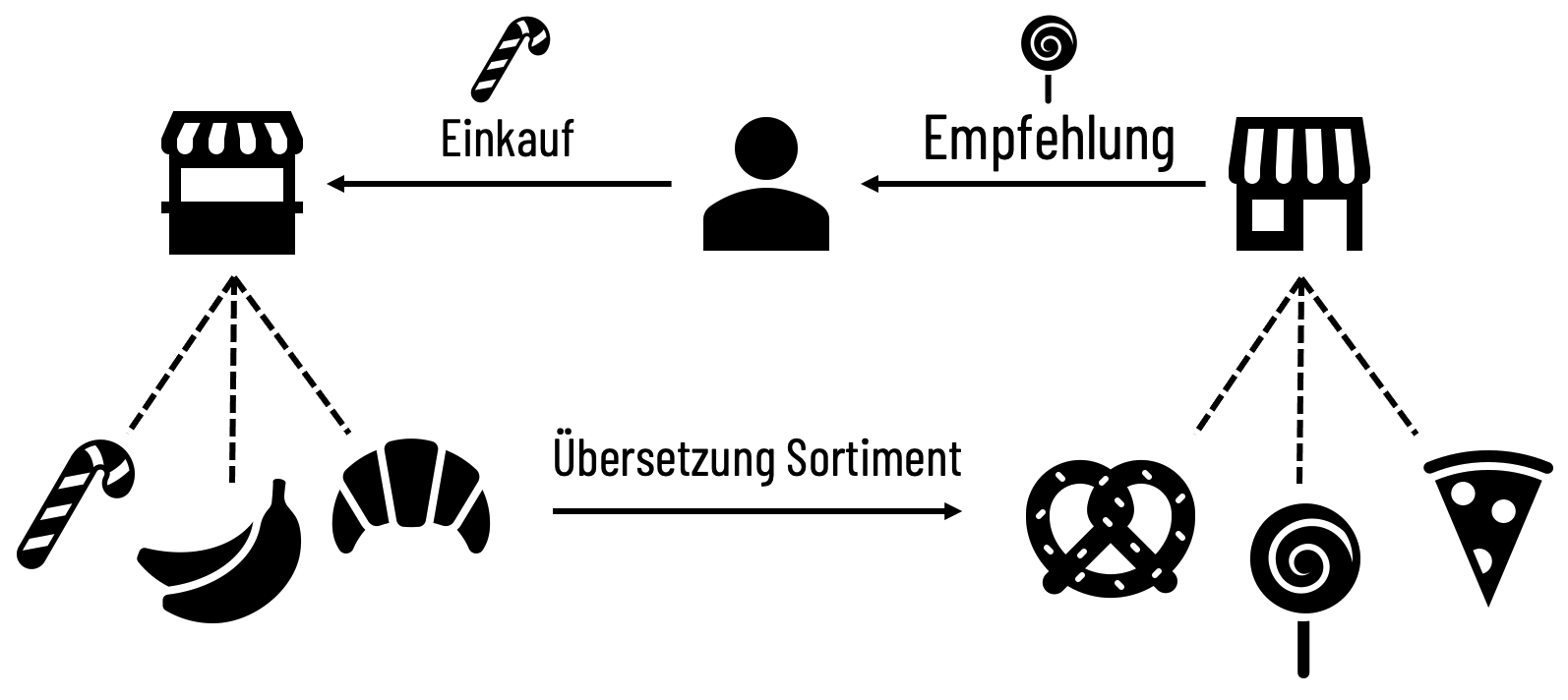

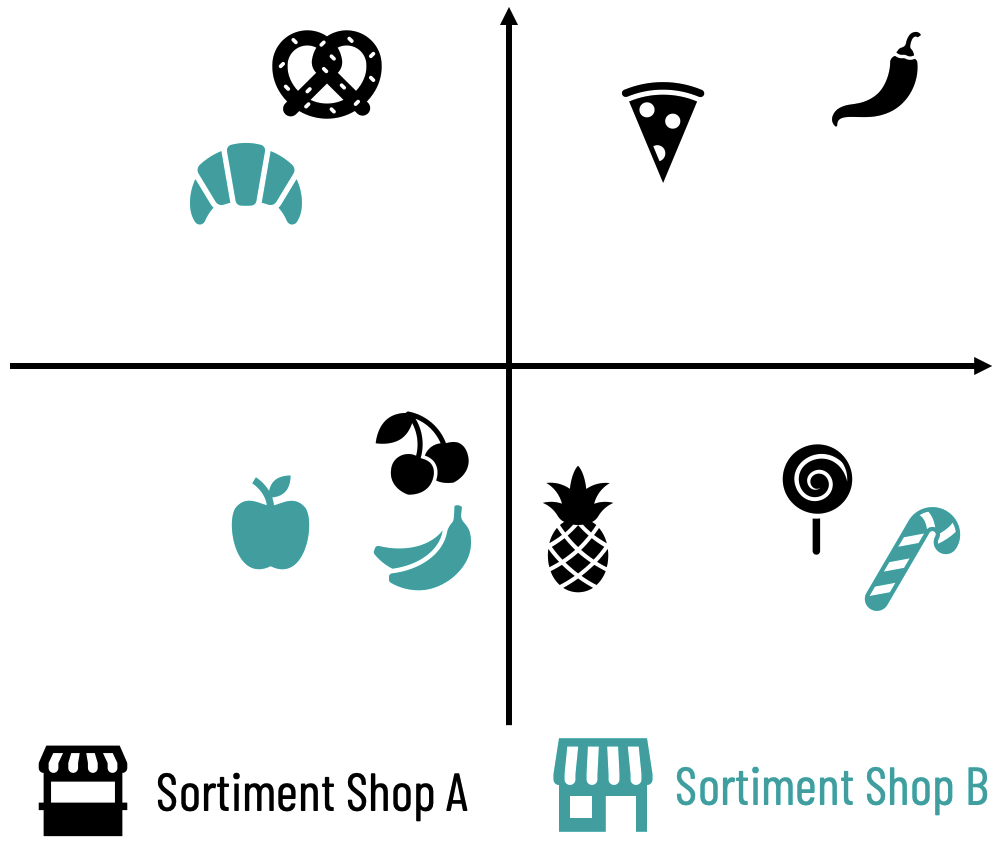

Die automatische Übersetzung von Produkt-Sortimenten zwischen Onlineshops ist nur ein Anwendungsfall für LLM-Technologien im E-Commerce Bereich. In den nächsten Jahren werden LLM-Technologien zunehmend ihren Nutzen in verschiedenen Aspekten des E-Commerce finden. Die Verbesserung der Suchfunktion in Onlineshops ist ein solcher Use Case, bei dem auf Suchanfragen wie „Geschenk-Ideen für meine Eltern“ endlich logisch reagiert und keine leeren Ergebnisseiten zurückgegeben werden.

Auch im Bereich der Produktbeschreibungen und -bewertungen können LLMs dazu beitragen, die Qualität und Genauigkeit der bereitgestellten Informationen zu erhöhen. So können sie beispielsweise automatisch relevante Informationen aus unterschiedlichen Quellen zusammenfassen und ansprechende, verständliche Produktbeschreibungen erstellen, die potenzielle Käufer ansprechen und informieren.

Insgesamt bieten LLM-Technologien ein großes Potenzial für den E-Commerce-Bereich, um sowohl die Kundenerfahrung als auch die Effizienz und Effektivität von Onlineshops zu verbessern. Die erfolgreiche Implementierung und Integration von LLMs in verschiedene Aspekte des E-Commerce wird in den kommenden Jahren entscheidend sein, um den wachsenden Anforderungen und Erwartungen der Kunden gerecht zu werden und wettbewerbsfähig zu bleiben.

dpunkt.verlag GmbH

dpunkt.verlag GmbH